“ 元象首个 MoE 大模型开源:无条件免费商用、4.2B 激活参数 头条 ”

元象发布XVERSE-MoE-A4.2B大模型 ,采用业界最前沿的混合专家模型架构Mixture of Experts,激活参数4.2B,效果即可媲美13B模型。

该模型全开源,无条件免费商用,让海量中小企业、研究者和开发者可在元象高性能“全家桶”中按需选用,推动低成本部署。

下载XVERSE-MoE-A4.2B大模型

- Hugging Facehttps://huggingface.co/xverse/XVERSE-MoE-A4.2B

- ModelScope魔搭https://modelscope.cn/models/xverse/XVERSE-MoE-A4.2B

- Githubhttps://github.com/xverse-ai/XVERSE-MoE-A4.2B

XVERSE-MoE-A4.2B两大优势

- 极致压缩用相同语料训练2.7万亿token,元象MoE实际激活参数量4.2B,效果“跳级”超越XVERSE-13B-2,仅用30%计算量,并减少50%训练时间。

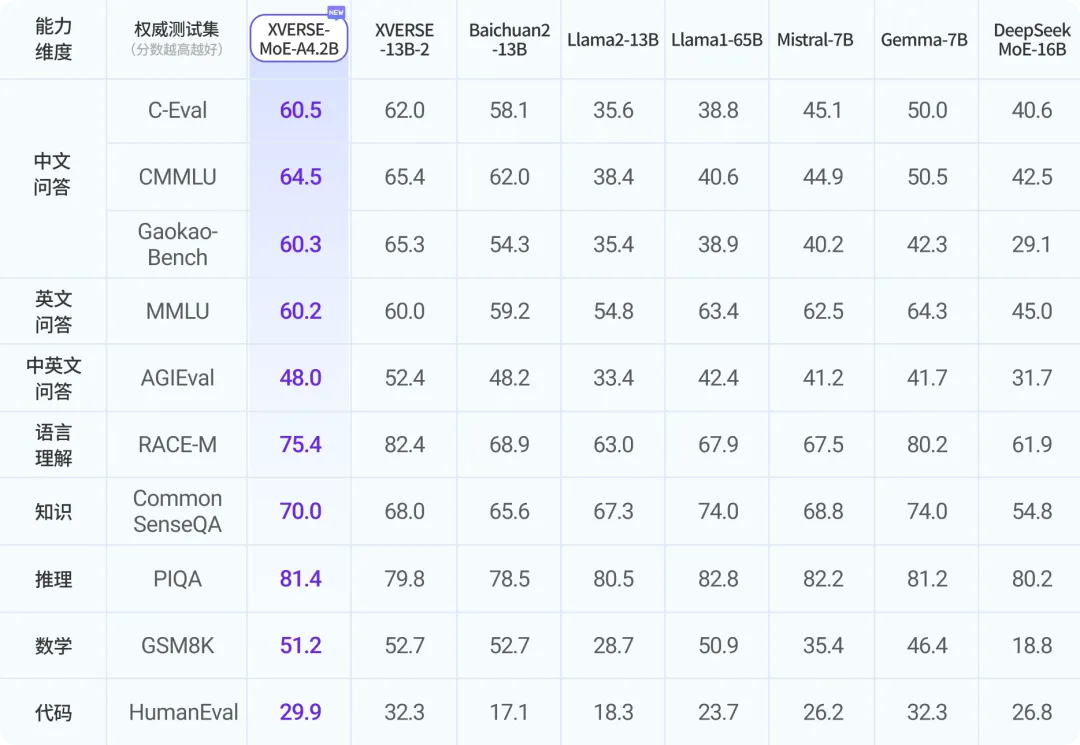

- 超凡性能在多个权威评测中,元象MoE效果大幅超越新晋业界顶流谷歌Gemma-7B和Mistral-7B、Meta开源标杆Llama2-13B等多个模型、并接近超大模型Llama1-65B。

XVERSE-MoE-A4.2B两大优势

- 极致压缩用相同语料训练2.7万亿token,元象MoE实际激活参数量4.2B,效果“跳级”超越XVERSE-13B-2,仅用30%计算量,并减少50%训练时间。

- 超凡性能在多个权威评测中,元象MoE效果大幅超越新晋业界顶流谷歌Gemma-7B和Mistral-7B、Meta开源标杆Llama2-13B等多个模型、并接近超大模型Llama1-65B。

权威测试集评测结果

权威测试集评测结果

每日一言

"<!doctype html> <html lang="Zh-cn"> <head> <meta http-equiv="Content-Type" content="text/html; charset=utf-8" /> <meta name="robots" content="noindex,nofollow"> <meta name="viewport" content="width=device-width, initial-scale=1.0, maximum-scale=1.0, user-scalable=no"/> <meta name="renderer" content="webkit"> <title>您请求的文件不存在!</title> <link type="text/css" rel="stylesheet" href="https://www.oick.cn/css/404.css" /> <link rel="shortcut icon" href="http://www.oick.cn/favicon.ico" type="image/x-icon" /> </head> <body> <div id="wrap"> <div> <img src="https://www.oick.cn/imgs/404.png" alt="404" /> </div> <div id="text"> <strong> <span></span> <a href="javascript:history.back()">返回上一页</a> </strong> </div> </div> <div class="animate below"></div> <div class="animate above"></div> </body> </html>"